基于虚拟属性学习的文本-图像行人检索方法

王成济

,

苏家威

,

罗志明

,

曹冬林

,

林耀进

,

李绍滋

软件学报  2023, Vol. 34 2023, Vol. 34 Issue (5): 2035-2050 Issue (5): 2035-2050 |

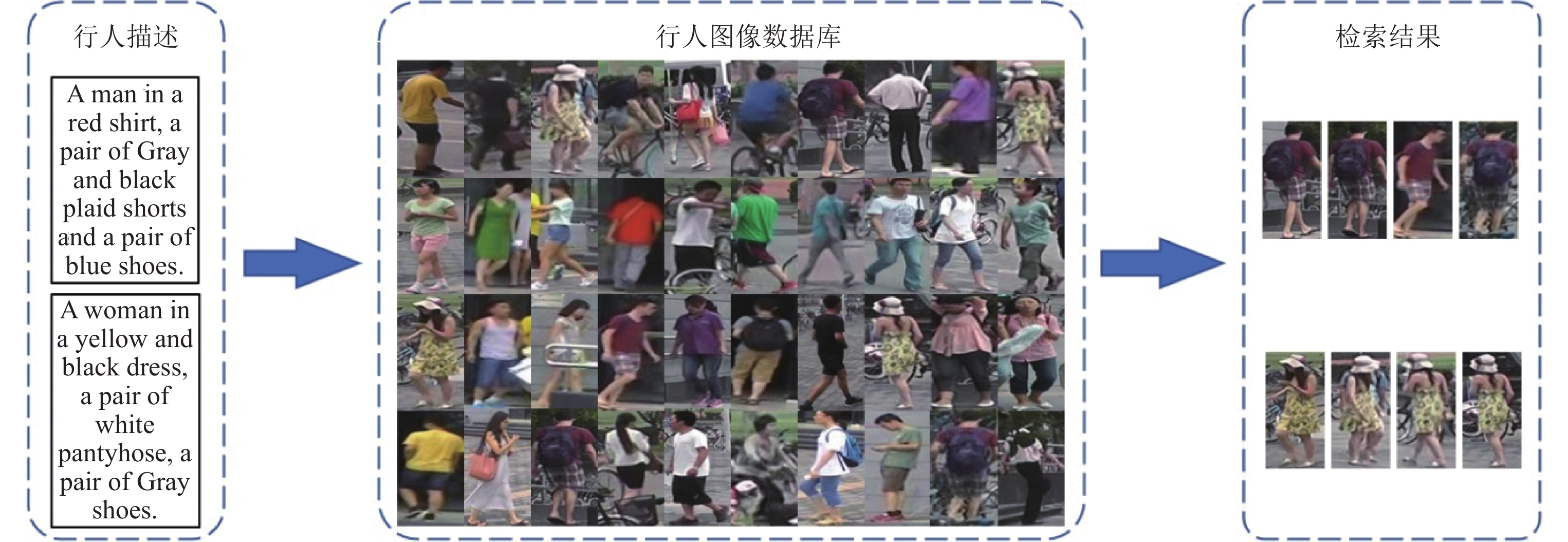

行人检索旨在从图像数据库或视频集中找到特定的行人, 达到跨时空行人跟踪的目的. 自动化地行人检索是智能安防系统的重要组成部分, 广泛应用于安防监控、群体性事件识别等. 行人检索技术是当前计算机视觉领域中具有极高研究和应用价值的前沿方向之一. 当前的行人检索方法可以根据输入数据类型的不同简要地分为两大类: 单模态行人检索[1-3]和跨模态行人检索[4-7]. 与基于素描画[4]或红外图像[5,6]的跨模态行人检索技术相比, 文本数据容易获取、适用场景多, 使得文本-图像跨模态行人检索开始受到业界的广泛关注. 文本-图像跨模态行人检索是跨媒体检索[8]和行人检索[9,10]的交叉研究领域. 如图1所示, 给定行人描述, 文本-图像跨模态行人检索旨在根据文本描述从图像数据库中找出目标行人. 对比其他行人检索技术, 文本-图像跨模态行人检索能够更加灵活、全面地满足复杂场景下的行人检索需求. 然而, 图像和文本的抽象层次不同, 不同类型数据间的“异构鸿沟”导致无法直接比较图像和文本的相似性. 同时算法还需要鉴别不同个体的细微差异以区分不同的行人. 这要求算法不仅要克服图像与文本间的“异构鸿沟”也要对比行人的局部细节. 因此, 文本-图像跨模态行人检索是一个极具挑战性的问题.

|

图 1 文本-图像跨模态行人检索示例 |

在大型数据集上预训练的特征提取模型隐式地学习到通用的语义知识. 研究人员提出借助预训练模型的表征能力提取多模态的行人特征表示[11-13]. 文献[11-13]使用在ImageNet数据集[14]预训练的卷积神经网络模型[15-17]提取视觉模态的行人特征表示. 文献[13]进一步引入预训练的基于变压器的双向编码语言模型(bidirectional encoder representations from Transformers, BERT)[18]提取文本特征表示. 这些方法[11-13]建立一个共同子空间, 将不同类型的数据映射到这个子空间中得到统一表征. 文献[11-13]直接使用距离度量方法计算文本与图像之间的相似性实现跨模态行人检索. 这类融合预训练技术的文本-图像跨模态行人检索方法专注于在全局上关联文本和图像, 然而无法应对细粒度给行人检索带来的挑战. 于是, 使用属性关联文本和图像的方法被提出. 典型的方法有AATE[19]和CMAAM[20]. AATE[19]提出有监督属性学习获取的属性相关的行人视觉表征可以提高特征的鉴别力. CMAAM[20]则认为应该同时从图像和文本中学习属性相关的行人特征表示. 属性是行人部位、着装、性别等的抽象描述, 编码细粒度的语义信息. 文献[19,20]已经通过实验证明属性学习可以有效地建立细粒度的跨模态语义关联. 然而属性标签难以获取、手工标注成本高昂, 致使这类方法在实践中表现不佳. CMAAM[20]提出使用名词短语作为属性标签. 但是, 不同文本对属性的描述存在差异导致获得的属性标签不准确. 认知科学的研究成果表明, 人脑能够自动地从输入中解耦出关键信息并关联不同输入类型的数据, 从而更加全面的认知外部世界[21]. 因此, 如何通过模拟人脑的认知过程, 在没有属性标注的情况下建立细粒度的跨模态语义关联, 是文本-图像跨模态行人检索亟待解决的关键问题.

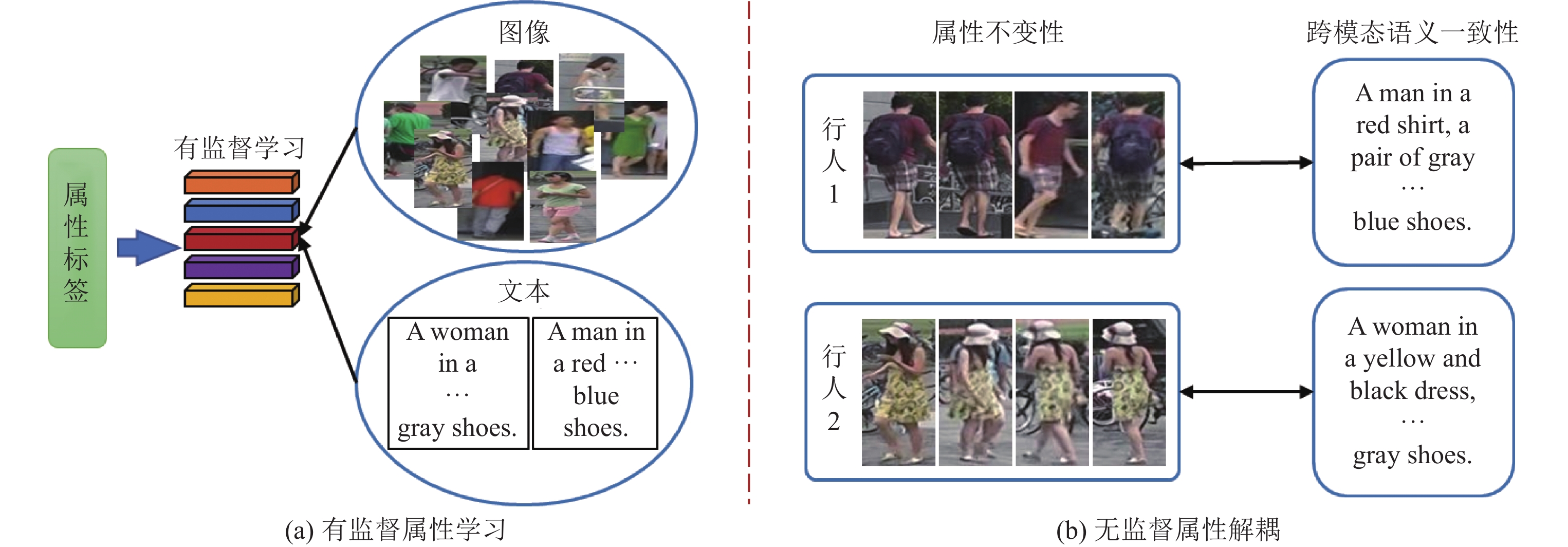

事实上, 属性是行人固有的特征具有不变性, 且描述同一行人的不同类型的数据存在天然的语义一致性. 其中, 语义一致性是指属性的模态无关性. 因此, 利用属性的不变性和跨模态语义一致性解耦行人的属性信息, 可以得到属性相关的特征. 其次, 属性之间存在依存关系, 例如“裙子”一般与“女性”同时出现. 这表明利用属性间的关联可以更好地解耦属性信息. 此外, 单一的属性不足以区分不同的行人. 与之不同的是属性的组合携带大量可用于识别行人身份的信息. 这表明充分地建模属性的全局上下文信息可以获得更加鲁棒的跨模态行人特征表示. 图2是有监督属性学习和无监督属性解耦的对比.

|

图 2 有监督属性学习与无监督属性解耦 |

然而, 现有的基于属性建立细粒度跨模态语义关联的方法依赖于属性标注, 这些方法利用有监督属性学习引导模型提取属性相关的特征. 但多模态行人数据的属性标签难以获取, 手工标注代价高等问题限制这类方法的应用. 因此, 如何在没有属性标签的情况下自动地解耦属性相关特征, 建立细粒度的跨模态语义关联. 本文提出基于虚拟属性学习的文本-图像行人检索方法, 利用行人的身份标签进行虚拟属性学习引导模型解耦属性相关特征, 通过虚拟属性建立细粒度的跨模态语义关联.

本文的主要贡献如下.

(1) 提出基于虚拟属性学习的文本-图像行人检索方法. 该方法无需标注属性标签就可以完成细粒度的跨模态关联分析与挖掘, 摆脱对属性标注的依赖.

(2)针对没有属性标签无法提取到属性相关特征的问题, 提出语义引导的属性解耦方法. 该方法使用行人的身份标签作为监督信号引导模型解耦属性相关特征. 无需属性标签就可以充分挖掘多样的属性信息, 从而建立细粒度的跨模态语义关联.

(3) 提出基于语义推理的特征学习模块, 利用属性间的共现关系构建语义图. 一方面, 通过语义图在属性之间交换信息, 补全缺失的属性信息; 另一方面, 多层图模型可以充分挖掘属性的上下文信息, 从而提升特征的识别能力.

通过在CUHK-PEDES数据集上的实验设计和分析, 验证了所提出方法的有效性. 在通用跨模态检索数据集Flickr30k上的实验证明了所提出方法的泛化性. 本文第1节介绍相关工作. 第2节介绍提出的基于虚拟属性学习的文本-图像行人检索方法. 第3节为实验设置与结果分析. 第4节为本文结论.

1 相关工作 1.1 文本-图像跨模态行人检索当前的文本-图像跨模态行人检索方法可以简要分为3类: 基于跨模态交互的方法、基于联合特征映射的方法和基于属性学习的方法.

基于跨模态交互的方法旨在通过文本与图像的跨模态交互计算文本与图像的相似度. Li等人[7]结合卷积神经网络(convolutional neural network, CNN)和递归神经网络(RNN)提出一个CNN-RNN模型. 该模型首先提取图像的全局特征, 分别计算图像特征与不同词语的相似度, 聚合图像与词语的相似度得到文本与图像的相似度. Li等人[22]在CNN-RNN模型的基础上提出使用行人身份标签挖掘难分样本以增加跨模态特征的相似性和不同人特征的差异. Chen等人[23]提出将图片均匀划分为49个子区域并计算每一个图像区域和不同词语的相关性, 构建文本与图像的细粒度关联. 通过对相关性取最大值得到文本与图像的相似度. Niu等人[24]将图像纵向切分为6个子区域并分别计算图像区域与名词短语的相关性并根据相关性聚合图像和文本的特征得到细粒度的跨模态行人特征表示. Niu等人[24]同时计算细粒度的和全局的图文相似度. Gao等人[25]基于跨模态注意力设计了一个文本引导的视觉特征增强模块, 建模不同图像区域与文本的关联. Jing等人[26]使用一个模态的局部特征引导并聚合另一个模态的局部特征, 得到双向对齐的跨模态行人局部特征表示. 基于跨模态交互的方法强制对齐所有的图像区域和文本, 这类方法认为细粒度匹配问题是解决文本-图像跨模态行人检索的关键. 然而文本只能描述有限的图像内容, 致使这类方法学习到错误的局部匹配导致错误的检索结果.

基于联合特征映射的方法将两个模态的数据映射到同一空间中. 在共享的特征空间中进行特征学习和跨模态匹配. Zhang等人[11]分别使用卷积神经网络和双向长短记忆神经网络提取图像和文本特征表示, 提出基于跨模态交叉投影的跨模态匹配损失和身份分类损失. Zheng等人[12]使用两个卷积神经网络分别提取图像和文本特征表示. 文献[13, 27]提出使用对抗学习减少模态差异. 也有一些文献进一步引入局部特征学习. Jing等人[28]认为使用图注意力建模名词短语间的关系可以提升特征的鉴别力. Liu等人[29]使用预训练的目标检测模型获取物体的特征表示后通过图模型聚合物体的特征表示得到行人的全局特征表示. 基于联合特征映射的方法致力于从全局上建立文本和图像的跨模态语义关联, 这类方法没有建立细粒度的跨模态语义关联导致提取的特征较为粗糙, 限制了模型性能.

基于属性学习的方法利用属性的跨模态语义一致性提取跨模态的细粒度语义表征, 从而建立细粒度的跨模态语义关联, 提升模型的检索精度. 具有代表性的方法有Aggarwal等人[20]提出的CMAAM和Wang等人[30]提出的ViTAA. Aggarwal等人[20]对整个数据集中的名词短语和名词进行聚类, 将类别中心作为属性标签进行有监督属性学习提取跨模态的属性相关特征. Wang等人[30]提出使用预训练的行人语义分割模型分割出行人不同的部位, 通过对齐行人的部位特征和名词短语获得跨模态的行人特征表示. Wang等人[30]认为分割得到的行人部位特征代表行人的属性特征, 对齐行人的部位特征和名词短语的特征可以得到细粒度的行人特征表示. 基于属性学习的方法对属性标签或者预训练的属性相关特征提取模型的依赖导致该方法在实践中表现不佳.

基于属性学习的方法融合了基于跨模态交互的方法和基于联合特征映射的方法的优点, 能够在细粒度上关联图像和文本同时具有较快的推理速度. 针对没有属性标签无法提取属性相关特征的问题, 提出基于虚拟属性学习的文本-图像行人检索方法. 与之前的方法不同, 本文所提出的方法无需属性标签和预训练的属性相关特征提取模型. 所提出的语义引导的属性解耦方法可以自动地从文本和图像中解耦出属性相关特征, 在细粒度上建立跨模态语义关联.

1.2 行人属性学习及其在行人检索中的应用属性是结构化的行人语义特征描述着装、发型、携带物体等诸多可识别的信息, 其对光照变化和视角变化都具有鲁棒性. 史金婉等人[31]认为属性编码的个性化的信息, 可以用于服装推荐. 郑鑫等人[32]在单模态行人检索中引入属性标签学习具有鉴别力的行人部位特征. 文献[33]认为可以使用属性检索目标行人图像. 与文本-图像跨模态行人检索一样, 使用属性检索行人图像是跨模态行人检索任务. 然而属性不具有唯一性, 使用属性作为输入可能会检索出多个表观相似的行人.

文献[19,20]引入有监督属性学习解决文本-图像跨模态行人检索问题. Zha等人[19]使用手工标注的属性学习属性相关的特征, 并融合属性相关的特征和图像特征获取更具有鉴别力的跨模态行人特征表示. Zha等人[19]只提取图像中的属性相关特征表示, 没有提取文本的属性相关特征表示. Aggarwal等人[20]提出使用数据集中的名词和名词短语作为属性标签. 作者对数据集中的名词和名词短语进行聚类, 将类别中心作为属性标签. 由于自然语言的多样性和复杂性, 使用聚类的方法获得的属性标签包含有大量噪声.

本文方法利用属性在细粒度上关联图像和文本提升特征的鉴别能力. 与上述方法不同, 本文方法基于属性的不变性和跨模态语义一致性, 在没有使用属性标签的前提下自动地解耦属性信息获取跨模态的属性相关特征, 提升模型检索精度.

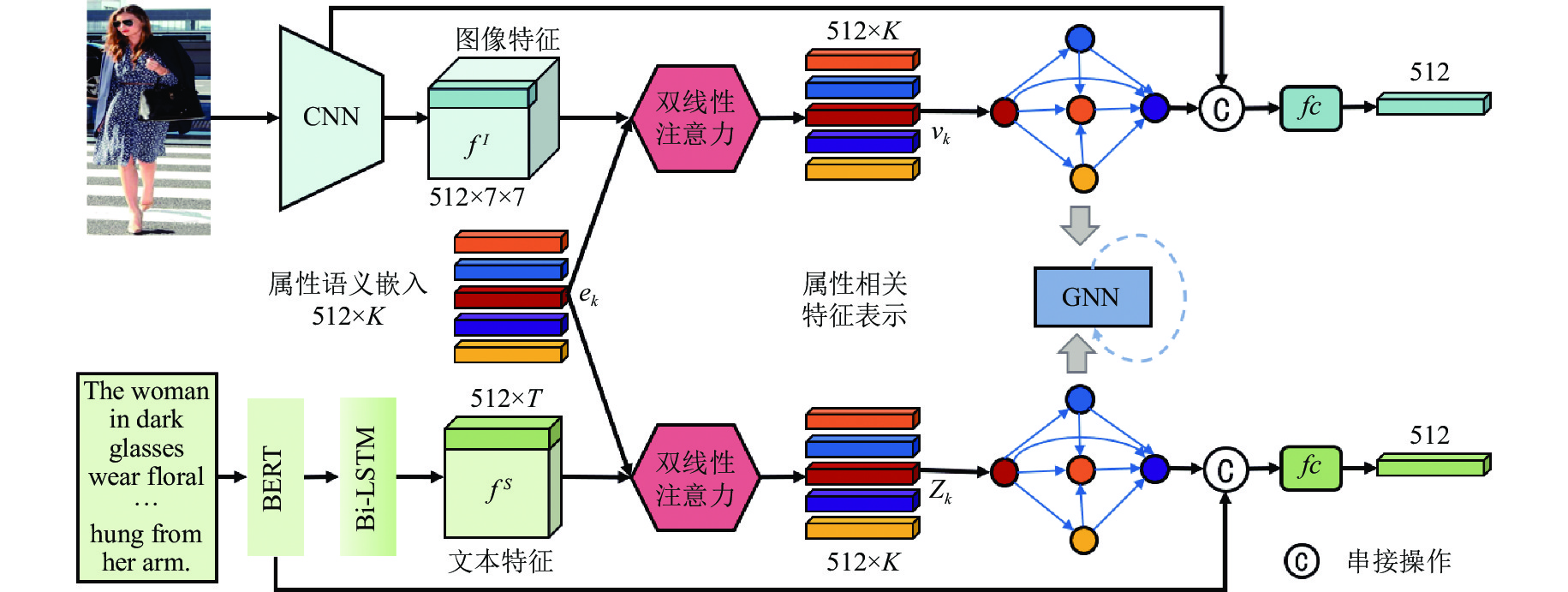

2 基于虚拟属性学习的文本-图像行人检索属性是与模态无关的细粒度语义信息. 提取行人属性相关特征能有效地建立细粒度跨模态语义关联, 提升特征的跨模态识别能力. 为摆脱对属性标签的依赖, 提出基于虚拟属性学习的文本-图像行人检索方法, 所提出方法的网络结构如图3所示. 针对两种模态的输入, 本文使用两个预训练模型分别提取图像和文本的特征表示. 语义引导的属性解耦使用双线性注意力(bilinear attention, BA)[34]计算图像或文本的局部特征与不同属性的语义相关性. 根据相关性聚合特征得到属性相关的特征表示. 基于语义推理的特征学习将属性作为图的节点、属性的共现概率作为边, 使用图神经网络(graph neural network, GNN)[35]建模属性的全局上下文, 获得具有鉴别力的跨模态行人特征表示.

|

图 3 本文方法整体框架示意图 |

下面给出文本-图像跨模态行人检索的形式化定义. 假定数据集为

如图3所示, 给定图像-文本对

| 表 1 预训练神经网络结构 |

语义引导的属性解耦模块旨在使用属性语义嵌入引导模型提取属性相关的特征表示. 属性语义嵌入编码了属性信息. 使用与模态无关的属性语义嵌入引导模型学习, 可以使得模型更加关注属性相关的图像区域或词语, 学习到跨模态的属性相关特征表示. 因此, 如何合理利用属性的不变性和跨模态语义一致性自动地解耦属性信息成为无监督属性解耦的关键问题. 受属性的跨模态一致性和行人属性的不变性的启发, 提出使用行人的身份标签作为监督信号, 引导模型进行属性解耦.

对于每一个图像区域

| ˜fIk,wh=PT(tanh((UTfIwh)⊙(VTek))) | (1) |

其中,

| ak,wh=Softmax(˜fIk,wh) | (2) |

最后, 使用加权求和的方式聚合所有位置的图像特征, 得到属性相关的图像特征表示. 与属性

| vk=∑w,hak,whfIwh | (3) |

重复上述过程

| qIk=I(tanh(wTkvk)) | (4) |

其中,

同理, 对于每一个词语

在得到输入的属性预测和行人的属性分布之后, 根据行人的属性不变性设计中心点损失函数, 给每一个行人提供一个属性分布中心, 使得同一行人不同样本的属性分布尽可能地靠近其属性分布中心缩小同一行人不同样本间的属性分布的距离. 采用如下损失函数约束同一行人不同样本的属性分布的距离:

| Lc=‖ | (5) |

其中,

本文设计基于属性的跨模态匹配损失限制身份标签相同的图像和文本的属性分布的距离小于身份标签不同的图像和文本的距离. 属性分布的距离定义如下:

| d\left( {{P^I}, {P^S}} \right) = 1 - \frac{{{{\left\| {{P^I} - {P^S}} \right\|}_1}}}{2} | (6) |

基于属性的跨模态匹配损失定义如下:

| {L_m} = {\left\{ {\begin{array}{*{20}{l}} {{{\left[ {0, \alpha - d\left( {{P^I}, {P^S}} \right)} \right]}_ + }} \\ {\left[ {0, d\left( {{P^I}, P_n^S} \right) - (1 - \alpha )} \right]_ +} \end{array}} \right. } | (7) |

其中,

为保证模型学习到多样化的属性相关特征提出的基于对比学习的属性解耦损失定义如下:

| {L_d} = - \frac{1}{K}\displaystyle\sum\limits_{k = 1}^K {q_k^I\log \left( {\frac{{\exp \left( {{w_k}{v_k}} \right)}}{{\displaystyle\sum\nolimits_h {\exp \left( {{w_h}{v_k}} \right)} }}} \right) + q_k^S\log \left( {\frac{{\exp \left( {{w_k}{{\textit{z}}_k}} \right)}}{{\displaystyle\sum\nolimits_h {\exp \left( {{w_h}{{\textit{z}}_k}} \right)} }}} \right)} | (8) |

最终的属性解耦损失函数定义如下:

| {L_{att}} = {L_c} + {L_m} + {L_d} | (9) |

属性之间存在语义关联, 单一属性缺少上下文信息不足以区分不同的行人. 对属性之间的关联进行建模可以很好地挖掘属性的上下文信息, 提升模型的跨模态表征能力. 基于语义推理的特征学习以属性相关特征为节点、属性之间的共现概率为边, 使用图神经网络(GNN)构造语义图, 基于图模型在属性之间交换信息, 对属性的全局上下文信息进行建模提升特征的跨模态识别能力.

首先, 构建语义图

| \left\{ { \begin{array}{l} a_k^t = \displaystyle\sum\nolimits_h {{e_{kh}}h_h^{t - 1}} \\ {\textit{z}}_k^t = \sigma ({W^{\textit{z}}}a_k^t + {U^{\textit{z}}}h_k^{t - 1}) \\ r_k^t = \sigma ({W^r}a_k^t + {U^r}h_k^{t - 1}) \\ \widetilde h_k^t = \tanh \left( {Wa_k^t + U\left( {r_k^t \odot h_k^{t - 1}} \right)} \right) \\ h_k^t = \left( {1 - {\textit{z}}_k^t} \right) \odot h_k^{t - 1} + {\textit{z}}_k^t \odot \widetilde h_k^t \end{array} } \right. | (10) |

其中,

| {o^t} = fc\left( {\left[ {h_1^t|| \ldots ||h_k^t} \right]} \right) | (11) |

其中,

为使得语义增强的图像和文本特征更好地保留行人的身份信息, 可以最大化特征与行人身份的相关性. 计算每个特征层输出的特征

| p(y|{o^t}) = \frac{{\exp \left( {w_y^{\rm{T}}{o^t}} \right)}}{{\displaystyle\sum\nolimits_{m = 1}^M {\exp \left( {w_m^{\rm{T}}{o^t}} \right)} }} | (12) |

其中,

| {L_{asr}} = - \sum\limits_{t = 1}^3 {\sum\nolimits_{{o^t} \in \left\{ {{o^{t, I}}, {o^{t, S}}} \right\}} {\log \left( {p\left( {y|{o^t}} \right)} \right)} } | (13) |

语义增强的特征可以提取丰富的细粒度语义信息, 但是仍缺少行人的全局信息. 图像和文本的全局特征分别编码图像和文本的空间分布, 携带具有鉴别力的全局信息. 将全局特征与语义增强的特征融合, 可以使得模型获得更加具有鉴别力的跨模态行人特征表示. 两个模态的行人特征表示如下:

| \left\{ { \begin{gathered} {F^I} = f{c^I}\left( {\left[ {{\mathit{avg\_pool}}({f^I})||{o^{3, I}}} \right]} \right) \\ {F^S} = f{c^S}\left( {\left[ {{\mathit{max\_pool}}({f^S})||{o^{3, S}}} \right]} \right) \\ \end{gathered} } \right. | (14) |

其中,

本文使用如下三元组损失训练模型:

| \begin{gathered} {L_r} = {\left[ {\beta - \cos ({F^I}, {F^S}) + \cos ({F^I}, {H^S})} \right]_ + } + {\left[ {\beta - \cos ({F^I}, {F^S}) + \cos ({H^I}, {F^S})} \right]_ + } \end{gathered} | (15) |

其中,

综合公式(9)、公式(13)和公式(15), 总体目标函数表示如下:

| L = {L_r} + {\lambda _1}{L_{att}} + {\lambda _2}{L_{asr}} | (16) |

其中,

本节先说明实验设置. 然后, 在公开数据集上与多种现有方法进行对比说明本文方法的性能. 之后, 通过销蚀实验分析本文方法各个部分的作用. 最后, 通过实验分析各个损失函数的重要性.

3.1 实验设置● 数据集. 为验证本文提出方法的有效性, 我们在当前公开的大型文本-图像跨模态行人检索数据集CUHK-PEDES[7]和跨模态检索数据集Flickr30k[36]上进行实验. CUHK-PEDES数据集包含130003个行人身份, 总共有40206张行人图像, 每张图像有两条文本描述. CUHK-PEDES数据集分为训练集、验证集和测试集, 3个子集中行人的身份互不重叠. 训练集中有11003个行人身份、验证集和测试集各有1000个行人身份. Flickr30k数据集有31783张图片, 每张图片标注5条文本描述, 其中29783张图片用于训练、验证集和测试集各有1000张图片. 两个数据集的训练集、验证集和测试集的详细划分如表2所示.

| 表 2 数据集划分 |

● 评价指标. 我们采用累计匹配特性(cumulative matching characteristic, CMC)评价模型的好坏. CMC值统计的是目标图像出现在前

● 实现细节. 本文使用TensorFlow实现图3所示的模型, 所有实验在配备有Intel Core i7-7700K CPU, GeForce GTX 1080Ti显卡, 64位Ubuntu 16.04系统, 32 GB内存的工作站上进行. 使用的预训练BERT模型(bert-as-service,

https://bert-as-service.readthedocs.io)提取文本特征. 输入图像的大小为224×224. 使用Adam优化器优化模型, 动量和衰减率分别设置为0.5和0.0005, 初始学习率设置为0.0002. 对于CUHK-PEDES数据集[7], 使用在ImageNet[14]上预训练的图像分类模型提取图像特征, 每次迭代输入32个匹配的图像-文本对, 遍历训练集50次. 对于Flickr30k数据集[36], 使用预训练的ResNet-152模型[16]提取图像特征. 在训练过程中, 先固定主干网络遍历数据集20次, 再训练整个模型遍历数据集15次, 每次迭代输入128个匹配的图像-文本对. 设置

● 测试设置. 在测试阶段, 分别提取图像特征

表3中对比本文方法与其他方法在CUHK-PEDES数据集上的检索结果. 预训练列出了方法所使用的预训练图像特征提取模型. 属性表示是否提取行人属性相关特征. 文本-图像跨模态行人检索旨在使用文本检索行人图像, 其他方法没有报告图像检索文本的结果. 与其他方法一样, 本文报告并对比文本检索图像的Rank-1、Rank-5和Rank-10准确率.

| 表 3 本文方法与其他方法在CUHK-PEDES数据集上的比较结果 (%) |

我们可以得到以下的观察结果.

第一, 当使用相同的主干网络时, 本文的方法在3个评价指标上都取得最好的结果. 与之前的方法相比, 本文方法的检索准确率有较大幅度的提升. 首先, 在仅使用预训练的CNN模型的方法, 本文方法的实验结果大幅领先于CMKA[38]. 其次, 对比使用更好的预训练模型的方法A-GANet (预训练的目标检测模型提取图像中物体的特征)[29]、PWA (预训练的人体姿态估计模型提取行人身体关键点的特征)[26]、ViTAA (预训练的行人语义分割模型提取行人的部位特征)[30], 本文的方法同样取得更好的结果. 这说明本文所提出的方法的优越性. 本文所提出的方法能够减少对属性标注的依赖也可以避免预训练模型带来的噪声干扰.

第二, 与使用有监督属性学习的方法比较. AATE[19]和CMAAM[20]引入有监督属性学习; ViTAA[30]使用重新训练的行人语义分割模型分割出行人的部位, 将行人的部位特征视为属性特征. 对比AATE[19]、CMAAM[20]、ViTAA[30]和本文方法, 本文提出的基于无监督属性解耦的方法具有明显优势. 本文方法无需属性标签就能够有效地利用属性的不变性和跨模态一致性解耦属性信息, 减少对属性标签和预训练模型的依赖.

综上所述, 本文方法在文本-图像跨模态行人检索任务上表现优异, 可以: 1)降低现有方法对属性标注的需求, 2)避免预训练模型的不确定性带来的干扰. 本文方法改善现有方法在特征鉴别力不足的问题. 实验结果表明, 提出的无监督属性解耦可以有效地弥合图像与文本间的异构鸿沟. 对比其他使用预训练模型的方法, 例如, PWA[26]、A-GANet[29]、ViTAA[30]需要针对不同任务重新训练预训练模型, 本文的方法具有更好的通用性.

表4对比本文方法与ViTAA[30]的检索结果. ViTAA使用行人语义分割模型提取行人的属性相关特征表示. 分割结果的好坏会直接影响模型的检索结果. 观察表4可以发现以下结果.

| 表 4 本文方法与ViTAA模型在CUHK-PEDES数据集的检索结果对比 |

第一, 不准确的预训练分割模型导致错误的检索结果. 第1个样例检索结果中的第2张和第4张图像中的行人没有“shorts”, ViTAA则根据腿部特征判定“wearing shorts”; 第5张图像中的男子的特征不明显, ViTAA受到背景的干扰判定其“wearing a black and white striped shirt”. 以上结果由于预训练的行人分割模型在原有数据集上过拟合导致分割出的行人部位不准确, 致使ViTAA学习到错误的匹配. 同样的情况也能够在第2个样例的检索结果中发现. 本文方法仅使用预训练CNN模型提取特征. 预训练CNN模型具有良好的泛化性. 本文方法能够避免由于预训练模型的不确定性导致的噪声干扰.

第二, ViTAA直接学习属性的跨模态匹配而忽略属性的全局上下文. 对属性的全局上下文建模可以更加全面和立体的提取行人特征表示. ViTAA直接学习属性的跨模态匹配. 会导致当某一个属性的特征不明显时, 模型会忽略该属性导致错误的匹配结果. 提出的基于语义推理的特征学习可以充分地建模属性的全局上下文获得更加鲁棒的跨模态行人特征表示.

3.2.2 在Flickr30k数据集上的检索结果为说明本文方法的泛化性, 表5对比本文方法与表3中的方法在Flickr30k数据集上的结果, 包括CMPC[11]、CMKA[38]和GARN[28]. 表2中的其他方法没有报告在Flickr30k数据集上的结果. 从表5中可以看到, 本文方法在其中5个评价指标上都取得最好的结果. 图像检索文本的Rank-1准确率只比GARN[28]低0.3%. 表5的结果表明本文方法具有良好的泛化性能.

| 表 5 本文方法与其他方法在Flickr30k数据集上的比较结果 (%) |

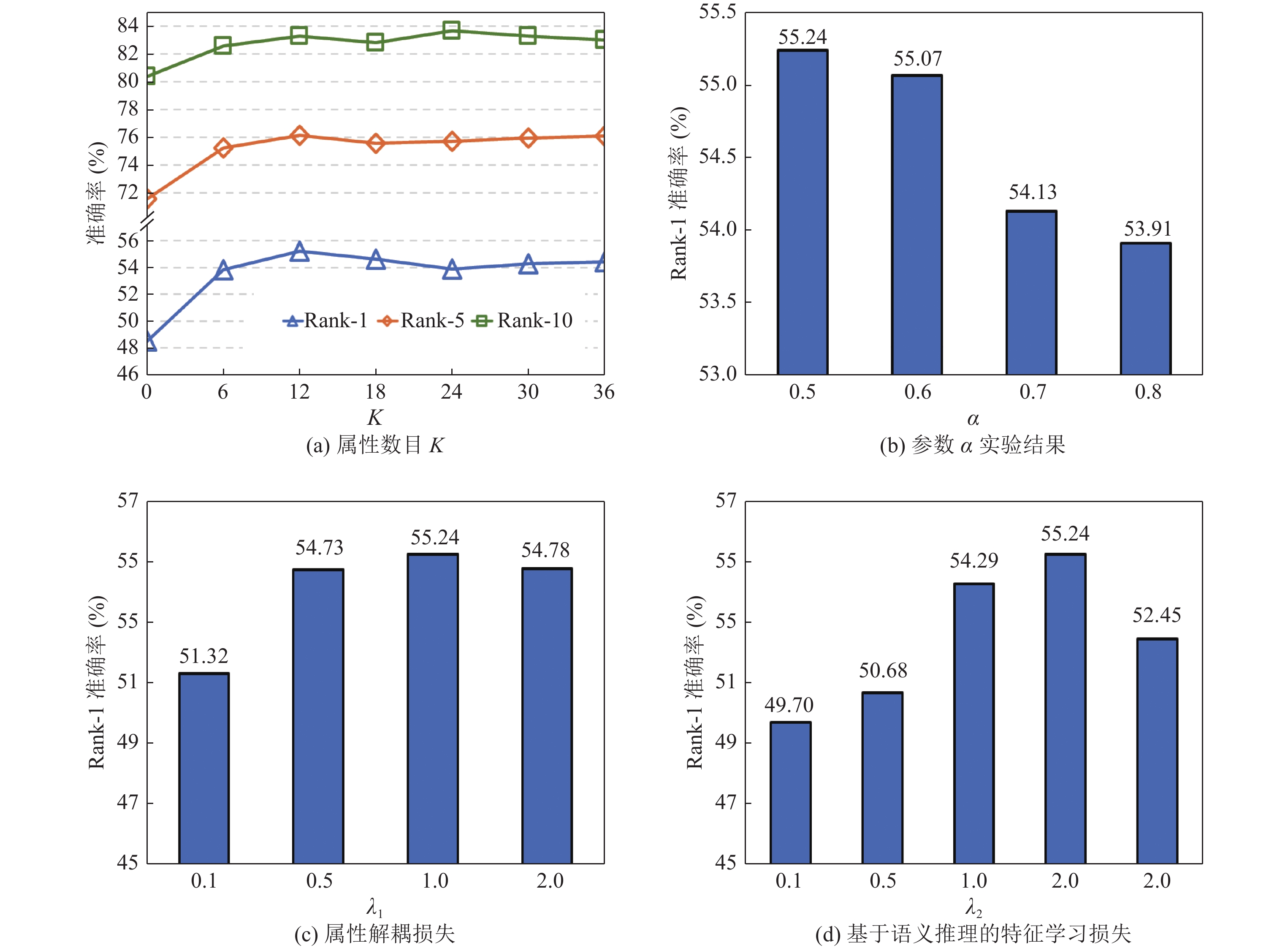

第一, 我们通过消减相应的模块分析不同部件(包括语义引导的属性解耦ATT、基于语义推理的特征学习ASR、串接语义增强的特征和全局特征FF及预训练语言模型BERT)的贡献. 销蚀实验结果见表6. 基准方法使用全局特征作为跨模态行人特征表示. 模型2将属性相关特征串接后映射到低维特征空间. 模型3将属性相关特征和全局特征串接后映射到低维特征空间. 模型4将语义增强的特征作为最终跨模态行人特征表示. 模型5是本文方法. 通过比较这些模型的实验结果, 我们可以得出以下结论: 1)语义引导的属性解耦模块有效地挖掘细粒度行人特征. 与基准方法对比, 模型使用语义引导的属性解耦后Rank-1准确率明显提高. 图4展示部分虚拟属性的注意力热图可视化结果, 从图4中可以看出模型会自动关注具有鉴别力的行人部位并能有效地对齐图像和文本. 这说明模态无关的虚拟属性的语义嵌入可以引导模型学习到跨模态的细粒度行人特征表示, 有效地建立细粒度的跨模态关联. 2)基于语义推理的特征学习, 基于属性构建的语义图可以有效地建模属性的全局上下文, 进一步增强特征的跨模态识别能力. 从表6中可以看到, 增加基于语义推理的特征学习模块后, 3个评价指标都有明显提升. 这是因为基于语义推理的特征学习模块在属性间交换信息, 不仅可以基于语义推理补全缺失的属性信息, 还充分考虑到属性与全局语义的关联. 3)全局特征和语义增强的特征是互补的. 语义增强的特征充分挖掘细粒度的行人语义特征. 全局特征提取了输入的空间分布, 融合全局特征和语义增强的特征可以提高特征的鉴别力和行人检索的准确率. 4)预训练的BERT模型可以提供更加鲁棒的词嵌入使得模型更好、更快的收敛.

| 表 6 在CUHK-PEDES数据集上, 每种模块的销蚀实验结果 (%) |

第二, 我们通过消减属性解耦模块损失函数对应项分析不同损失(包括中心点损失函数

|

图 4 虚拟属性的注意力热图可视化结果(红色越深表示相关性越高) |

| 表 7 在CUHK-PEDES数据集上, 属性解耦模块损失函数的销蚀实验结果 |

在本实验中, 通过改变

|

Fig. 5 The experimental results for varying

|

本文方法具有较高的检索效率和较好的可解释性. 本文提出的方法使用向量表示图像和文本, 通过比较向量的相似度能够实现快速地检索. 虚拟属性学习可以在细粒度上建立跨模态语义关联增强方法的可解释性. 但虚拟属性不是真实的属性. 从图4的可视化结果可以看到, 模型会反复激活相同的区域, 这说明所学习到的虚拟属性缺乏多样性. 同时不同行人的同一个属性会激活不同的行人部位, 这说明学习到的虚拟属性缺乏一致性. 产生这种结果的可能原因是所使用的属性语义嵌入是随机初始化的, 在没有属性标签的情况下模型会更多地关注对齐图像和文本. 本文方法无法应对多模态语义理解中的不确定性问题[39]. 多模态语义理解中有两种不确定性: 1)模态信息的不确定性, 由于文本只能描述有限的图像内容, 这导致同一条文本描述可能存在多个对应的行人, 本文方法没有考虑到这种情况. 2)模态间关联的不确定性, 各个模态上的信息分布是不确定的, 这导致模态间的关联是不确定的和模糊的.

4 结 论本文提出基于虚拟属性学习的文本-图像行人检索方法. 第一, 基于属性的不变性和语义一致性提出语义引导的属性解耦方法. 该方法可以充分地解耦出多样化的属性信息并有效地利用行人属性建立细粒度的跨模态语义关联减少不同模态的异构鸿沟. 第二, 提出的基于语义推理的特征学习模块利用属性构建的语义图模型有效地增强特征的跨模态识别能力. 所提出的方法降低了对数据的标注要求, 通过在公开的文本-图像行人检索数据集和跨模态检索数据集上的实验对比, 表明了本文方法的有效性. 本文提出的方法可以应用于智能视频监控系统中, 比如, 协助办案人员快速筛查可疑人员、在人流量较大的场所(机场、火车站、游乐场等)寻找走失儿童或老人等.

本文提出的基于属性学习的文本-图像行人检索方法没有考虑到属性类别的不平衡问题. 真实数据中不同的属性类之间是不平衡. 下一步工作拟引入代价敏感学习对不同属性给予不同的权重. 并尝试采用聚类分析技术对图像和文本进行聚类. 使用类别中心初始化属性的语义嵌入, 根据聚类的结果对不同属性赋予不同权重. 未来还可以围绕多模态语义理解中的不确定性问题开展研究工作.

| [1] |

Zheng L, Shen LY, Tian L, Wang SJ, Wang JD, Tian Q. Scalable person re-identification: A benchmark. In: Proc. of the 2015 IEEE Int’l Conf. on Computer Vision (ICCV). Santiago: IEEE, 2015. 1116–1124.

|

| [2] |

Zhong Z, Zheng L, Cao DL, Li SZ. Re-ranking person re-identification with k-reciprocal encoding. In: Proc. of the 2017 IEEE Conf. on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017. 3652–3661.

|

| [3] |

Xiao T, Li S, Wang BC, Lin L, Wang XG. Joint detection and identification feature learning for person search. In: Proc. of the 2017 IEEE Conf. on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017. 3376–3385.

|

| [4] |

Pang L, Wang YW, Song YZ, Huang TJ, Tian YH. Cross-domain adversarial feature learning for sketch re-identification. In: Proc. of the 26th ACM Int’l Conf. on Multimedia. Seoul: ACM, 2018. 609–617.

|

| [5] |

Wu AC, Zheng WS, Yu HX, Gong SG, Lai JH. RGB-infrared cross-modality person re-identification. In: Proc. of the 2017 IEEE Conf. on Computer Vision (ICCV). Venice: IEEE, 2017. 5390–5399.

|

| [6] |

Nguyen DT, Hong HG, Kim KW, Park KR. Person recognition system based on a combination of body images from visible light and thermal cameras. Sensors, 2017, 17(3): 605.

[doi:10.3390/s17030605] |

| [7] |

Li S, Xiao T, Li HS, Zhou BL, Yue DY, Wang XG. Person search with natural language description. In: Proc. of the 2017 IEEE Conf. on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017. 5187–5196.

|

| [8] |

Zhuo YK, Qi JW, Peng YX. Cross-media deep fine-grained correlation learning. Ruan Jian Xue Bao/Journal of Software, 2019, 30(4): 884–895 (in Chinese with English abstract). http://www.jos.org.cn/1000-9825/5664.htm

|

| [9] |

Luo H, Jiang W, Fan X, Zhang SP. A survey on deep learning based person re-identification. Acta Automatica Sinica, 2019, 45(11): 2032-2049(in Chinese with English abstract).

[doi:10.16383/j.aas.c180154] |

| [10] |

Qi L, Yu PZ, Gao Y. Research on weak-supervised person re-identification. Ruan Jian Xue Bao/Journal of Software, 2020, 31(9): 2883−2902 (in Chinese with English abstract). http://www.jos.org.cn/1000-9825/6083.htm

|

| [11] |

Zhang Y, Lu HC. Deep cross-modal projection learning for image-text matching. In: Proc. of the 15th European Conf. on Computer Vision. Munich: Springer, 2018. 707–723.

|

| [12] |

Zheng ZD, Zheng L, Garrett M, Yang Y, Xu ML, Shen YD. Dual-path convolutional image-text embeddings with instance loss. ACM Trans. on Multimedia Computing, Communications, and Applications, 2020, 16(2): 1-23.

[doi:10.1145/3383184] |

| [13] |

Sarafianos N, Xu X, Kakadiaris I. Adversarial representation learning for text-to-image matching. In: Proc. of the 2019 IEEE/CVF Int’l Conf. on Computer Vision (ICCV). Seoul: IEEE, 2019. 5813–5823.

|

| [14] |

Deng J, Dong W, Socher R, Li LJ, Li K, Fei-Fei L. ImageNet: A large-scale hierarchical image database. In: Proc. of the 2019 IEEE Conf. on Computer Vision and Pattern Recognition. Miami: IEEE, 2009. 248–255.

|

| [15] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition. In: Proc. of the 2nd Int’l Conf. on Learning Representations (ICLR). San Diego: ICLR, 2015. 1–14.

|

| [16] |

He KM, Zhang XY, Ren SQ, Sun J. Deep residual learning for image recognition. In: Proc. of the 2016 IEEE Conf. on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016. 770–778.

|

| [17] |

Howard AG, Zhu ML, Chen B, Kalenichenko D, Wang WJ, Weyand T, Andreetto M, Adam H. MobileNets: Efficient convolutional neural networks for mobile vision applications. arXiv:1704.04861, 2017.

|

| [18] |

Devlin J, Chang MW, Lee K, Toutanova K. BERT: Pre-training of deep bidirectional transformers for language understanding. In: Proc. of the 2019 Conf. of the North American Chapter of the Association for Computational Linguistics (NAACL). Minneapolis: Association for Computational Linguistics, 2019. 4171–4186.

|

| [19] |

Zha ZJ, Liu JW, Chen D, Wu F. Adversarial attribute-text embedding for person search with natural language query. IEEE Trans. on Multimedia, 2020, 22(7): 1836-1846.

[doi:10.1109/TMM.2020.2972168] |

| [20] |

Aggarwal S, Babu RV, Chakraborty A. Text-based person search via attribute-aided matching. In: Proc. of the 2020 IEEE Winter Conf. on Applications of Computer Vision (WACV). Snowmass: IEEE, 2020. 2617–2625.

|

| [21] |

Dayan P, Abbott LF. Theoretical Neuroscience: Computational and Mathematical Modeling of Neural Systems. London: The MIT Press, 2005.

|

| [22] |

Li S, Xiao T, Li HS, Yang W, Wang XG. Identity-aware textual-visual matching with latent co-attention. In: Proc. of the 2017 IEEE Conf. on Computer Vision. Venice: IEEE, 2017. 1890–1899.

|

| [23] |

Chen TL, Xu CL, Luo JB. Improving text-based person search by spatial matching and adaptive threshold. In: Proc. of the 2018 IEEE Winter Conf. on Applications of Computer Vision (WACV). Lake Tahoe: IEEE, 2018. 1879–1887.

|

| [24] |

Niu K, Huang Y, Ouyang WL, Wang L. Improving description-based person re-identification by multi-granularity image-text alignments. IEEE Trans. on Image Processing, 2020, 29: 5542-5556.

[doi:10.1109/TIP.2020.2984883] |

| [25] |

Gao LY, Niu K, Ma ZH, Jiao BL, Tan TH, Wang P. Text-guided visual feature refinement for text-based person search. In: Proc. of the 2021 Int’l Conf. on Multimedia Retrieval. Taipei: ACM, 2021. 118–126.

|

| [26] |

Jing Y, Si CY, Wang JB, Wang W, Wang L, Tan TN. Pose-guided multi-granularity attention network for text-based person search. Proc. of the AAAI Conf. on Artificial Intelligence, 2020, 34(7): 11189–11196.

|

| [27] |

Chen W, Liu Y, Bakker EM, Lew MS. Integrating information theory and adversarial learning for cross-modal retrieval. Pattern Recognition, 2021, 117: 107983.

[doi:10.1016/j.patcog.2021.107983] |

| [28] |

Jing Y, Wang W, Wang L, Tan TN. Learning aligned image-text representations using graph attentive relational network. IEEE Trans. on Image Processing, 2021, 30: 1840-1852.

[doi:10.1109/TIP.2020.3048627] |

| [29] |

Liu JW, Zha ZJ, Hong RC, Wang M, Zhang YD. Deep adversarial graph attention convolution network for text-based person search. In: Proc. of the 2019 ACM Int’l Conf. on Multimedia. Nice: ACM, 2019. 665–673.

|

| [30] |

Wang Z, Fang ZY, Wang J, Yang YZ. ViTAA: Visual-textual attributes alignment in person search by natural language. In: Proc. of the 16th European Conf. on Computer Vision. Glasgow: Springer, 2020. 402–420.

|

| [31] |

Shi JW, Song XM, Liu ZX, Nie LQ. Fashion graph-enhanced personalized complementary clothing recommendation. Journal of Cyber Security, 2021, 6(5): 181-198(in Chinese with English abstract).

[doi:10.19363/J.cnki.cn10-1380/tn.2021.09.14] |

| [32] |

Zheng X, Lin L, Ye M, Wang L, He CL. Improving person re-identification by attention and multi-attributes. Journal of Image and Graphics, 2020, 25(5): 936-945(in Chinese with English abstract).

[doi:10.11834/jig.190185] |

| [33] |

Dong Q, Zhu XT, Gong SG. Person search by text attribute query as zero-shot learning. In: Proc. of the 2019 IEEE/CVF Int’l Conf. on Computer Vision (ICCV). Seoul: IEEE, 2019. 3652–3661.

|

| [34] |

Kim JH, Jun J, Zhang BT. Bilinear attention networks. In: Proc. of the 32nd Conf. on Neural Information Processing Systems. Montréal: NeurIPS, 2018. 1571–1581.

|

| [35] |

Li YJ, Tarlow D, Brockschmidt M, Zemel RS. Gated graph sequence neural networks. In: Proc. of the 4th Int’l Conf. on Learning Representations (ICLR). San Juan: ICLR, 2016. 1–20.

|

| [36] |

Young P, Lai A, Hodosh M, Hockenmaier J. From image descriptions to visual denotations: New similarity metrics for semantic inference over event descriptions. Trans. of the Association for Computational Linguistics, 2014, 2: 67-78.

[doi:10.1162/tacl_a_00166] |

| [37] |

Chen DP, Li HS, Liu XH, Shen YT, Shao J, Yuan ZJ, Wang XG. Improving deep visual representation for person re-identification by global and local image-language association. In: Proc. of the 15th European Conf. on Computer Vision. Munich: Springer, 2018. 56–73.

|

| [38] |

Chen YC, Huang R, Chang H, Tan CQ, Xue T, Ma BP. Cross-modal knowledge adaptation for language-based person search. IEEE Trans. on Image Processing, 2021, 30: 4057-4069.

[doi:10.1109/TIP.2021.3068825] |

| [39] |

Xu T, Zhou PL, Chen EH. Uncertainty in multimodal semantic understanding. Communications of the CAAI, 2020, 10(9): 7-11(in Chinese with English abstract).

|

| [8] |

卓昀侃, 綦金玮, 彭宇新. 跨媒体深层细粒度关联学习方法. 软件学报, 2019, 30(4): 884–895. http://www.jos.org.cn/1000-9825/5664.htm

|

| [9] |

罗浩, 姜伟, 范星, 张思朋. 基于深度学习的行人重识别研究进展. 自动化学报, 2019, 45(11): 2032-2049.

[doi:10.16383/j.aas.c180154] |

| [10] |

祁磊, 于沛泽, 高阳. 弱监督场景下的行人重识别研究综述. 软件学报, 2020, 31(9): 2883−2902. http://www.jos.org.cn/1000-9825/6083.htm

|

| [31] |

史金婉, 宋雪萌, 刘子鑫, 聂礼强. 基于时尚图谱增强的个性化互补服装推荐. 信息安全学报, 2021, 6(5): 181-198.

[doi:10.19363/J.cnki.cn10-1380/tn.2021.09.14] |

| [32] |

郑鑫, 林兰, 叶茂, 王丽, 贺春林. 结合注意力机制和多属性分类的行人再识别. 中国图象图形学报, 2020, 25(5): 936-945.

[doi:10.11834/jig.190185] |

| [39] |

徐童, 周培伦, 陈恩红. 多模态语义理解中的不确定性. 中国人工智能学会通讯, 2020, 10(9): 7-11.

|