基于自监督知识的无监督新集域适应学习

汪云云

,

孙顾威

,

赵国祥

,

薛晖

软件学报  2022, Vol. 33 2022, Vol. 33 Issue (4): 1170-1182 Issue (4): 1170-1182 |

相较于传统机器学习模型, 基于大数据的深度学习模型能让预测性能得到显著提升. 然而, 深度网络等监督模型的训练往往依赖大量的有标记数据. 在真实学习任务中, 数据标注通常需要人工参与和相关的专业知识, 耗时耗力, 代价高昂; 此外, 学习模型对新环境和新任务的适应能力弱, 当面对与训练场景不同的学习环境时, 需对新数据进行标注, 并重新训练学习模型. 域适应(domain adaptation, DA)[1]学习旨在利用相关但不同的任务域辅助当前任务域的学习, 是缓解上述数据标注稀缺问题和提升模型适应能力的有效途径之一. 目前, 目标域中无任何标注信息的无监督域适应(unsupervised DA, UDA)是域适应学习中最具挑战和备受关注的研究方向.

在UDA中, 当前关注的任务域为目标域(target domain), 其他相关但不同的任务域为源域(source domain).学习目标是: 将相关的源域知识迁移至目标域中, 以提升目标域的学习性能. 由于受到如光照、噪声、角度变化以及物体自身差异的影响, 目标域与源域的样本分布往往存在差异. 因此, 当前域适应工作大多致力于减少域间的样本分布差异, 包括边缘分布和条件分布差异, 通过分布差异最小化或域混淆等策略对齐域间的特征分布. 再通过源域经验风险最小化, 将源域中的类判别知识迁移至目标域中, 指导目标域的分类学习[1]. 这些工作通常假设领域间的类标签空间一致或同构.

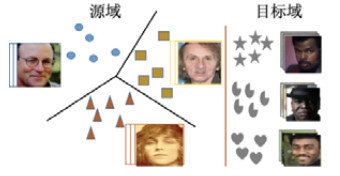

而在现实的开放动态环境中, 样本的类别无法恒定[2]. 此时, 域间的标签空间很可能存在差异, 源域或目标域中会出现域非共享类别. 假设域间仍存在部分共享类别, 源域中包含非共享类的学习问题称为部分域适应(partial DA, PDA)[2], 而目标域中包含新类别的学习问题为开集域适应(open-set DA, OSDA)[2]. 针对上述问题, 现有工作致力于识别域间的共享类别并迁移共享类知识[2]. 但在极端条件下, 域间可能不存在任何共享类别. 如在跨种族人脸迁移和识别中, 源域和目标域中人脸数据隶属于不同种族, 除数据分布差异外, 域间的类别也是完全无重叠的, 如图 1所示. 为方便后续介绍, 本文称该类学习问题为新集域适应(new-set DA, NSDA). 传统域适应方法在解决NSDA时会有如下问题: 1) 由于源域与目标域不存在共享类, 直接进行域特征对齐和知识迁移可能会引起负迁移现象; 2) 域间类别集合无交集, 基于源域学习所获分类器无法用于目标域数据分类. NSDA的学习目标与零次学习(zero-shot learning)[3]相似, 训练学习模型以识别从未见过的类别样例. 但零次学习通常需要辅助信息, 例如属性描述、文本描述或层次结构关系等[4], 而在NSDA学习中不会给定任何语义或属性信息. 此外, 新类别发现(new category discovery)[5]旨在对未见类别样本进行预测, 但在学习中不考虑已知类和新类别间的分布迁移.

|

图 1 源域和目标域间无任何共享类别的域适应学习 |

针对NSDA学习场景, 本文提出了基于自监督知识的无监督新集域适应学习方法SUNDA. 一方面, 源域和目标域间无任何共享类别, 对源域样本正确分类不一定有助于正确区分目标域中类别. 为此, 挖掘和迁移源域中的样本对比知识. 样本对比知识与具体的类别标签无关, 用于描述样本对是否源于同一类别. 将其迁移至目标域, 帮助实现目标域样本对的有效判别, 生成强判别能力特征. 另一方面, 试图利用目标域的自监督知识指导源域知识迁移. 首先, 使用自监督预训练学习源域和目标域的底层特征, 并在后续训练中固定特征生成网络的前几层参数, 以保留目标域中有用信息. 进一步, 由于域间类别集合无交集, 域适应后源域分类器无法直接对目标域样本分类, 利用基于图的自监督学习实现目标域样本分类. 具体地, 将目标域样本多分类问题转化为判定样本对是否属于同类别的二分类问题, 并通过目标域的生成特征给样本对赋予伪标签, 实现目标域样本分类. SUNDA方法的特点可总结如下.

1) 采用自监督预训练, 学习源域和目标域数据的底层特征, 以保存目标域信息;

2) 将源域的样本对比知识迁移至目标域, 辅助目标域生成类判别特征. 样本对比知识与具体类别标签无关, 因此源域和目标域无需包含共享类别;

3) 通过目标域中基于图的自监督知识指导知识迁移, 同时解决NSDA中目标域样本分类问题.

在数字和人脸数据集上, 将SUNDA与无监督域适应、无监督聚类以及新类发现算法进行性能对比, 实验验证了该方法的有效性.

1 相关工作 1.1 无监督域适应域适应学习旨在将一个或多个不同但相关源域的知识迁移至目标域, 以解决目标域中样本标注稀缺等问题. 近年来, 域适应方法相继涌现, 可大致分为3类[1]: 基于差异的方法、基于对抗的方法以及基于重构的方法. 基于差异的域适应方法通过域间的分布差异最小化减少域间的分布距离. 常用的差异性度量包括最大均值差异(maximum mean discrepancy, MMD)[6]、KL散度[7]和Wasserstein距离[8]等. 基于对抗的方法[9, 10]通常利用域判别器(domain discriminator)区分域间样本, 同时, 训练特征提取器用于混淆域判别器, 生成域不变特征. Saito等人[11]则通过两个源域分类器间的对抗学习, 实现域间的条件分布对齐. 基于重构的方法利用对抗方式生成其他域样本, 实现风格迁移, 如cycle-GAN[12]和CyCADA[13]等方法.

上述方式主要面向类标签空间一致的迁移学习场景. 而在现实学习任务中, 域间的标签空间很可能存在差异, 因此, 面向差异标签空间的迁移学习方法也在近期被相继提出[14−22]. 针对PDA, Cao等人[14]使用多个类级别和实例级别的权重机制实现各类的单独对抗; Zhang等人[15]构造辅助域判别器用于评估源域样本和目标域间的相似性. ETN (example transfer network)方法[16]利用递进式加权策略度量源域样本的可迁移性. OSDA[17]旨在将目标域中的共享类样本正确分类, 同时拒绝新的未知类样本. 如: OSBP (open set domain adaptation by backpropagation)[17]通过对抗方式判别域共享和非共享类; SAT (separate to adapt)[18]采用由粗到细粒度的加权方式为目标域样本赋权重, 描述其属于域共享和私有类的概率. 通用域适应方法UAN (universal domain adaptation)[21]对未知类的所属域别不作任何假设, 同时利用与源域的相似性和条件熵两种度量, 分别为源域和目标域样本赋权值, 以区分域共享和非共享类别. Saito等人[22]基于自监督学习, 通过近邻聚类和最小化熵方式拉近域共享类, 同时分离域非共享类.

1.2 自监督学习自监督学习(self-supervised learning, SSL)[23]是一种新的无监督学习范式, 旨在根据数据自身属性免费生成非目标标签, 以减少学习任务对大量标注数据的依赖. SSL通过创建免人工标注的前置(pretext)任务为特征学习提供代理的监督信号, 获得有益于下游(downstream)任务的特征表示. SSL的关键是前置任务的设计, 即如何依据数据属性自动生成免费的非目标标签. 依据属性, 自监督学习主要分为生成方法和对比方法. 生成方法主要针对图像或视频数据, 通过数据重建等方式人工构造数据标签, 并学习视觉特征, 如图像着色[23]、预测补丁的相对位置[24]、将图片裁剪后预测正确的拼图顺序[25]以及将图片随机旋转(0°, 90°, 180°, 270°)后预测旋转角度[26]等方法. 对比方法则关注样本间的对比知识, 旨在通过对比而非辅助标签学习特征, 实现样本间的有效区分. MOCO (momentum contrast)[27]将对比学习视为字典查找, 利用对比损失将编码查询与编码键字典进行匹配, 用于训练视觉表示编码器; SimCLR[28]通过最大化同一数据示例的不同增强视图间一致性, 以及不同数据示例的增强视图间差异性, 学习特征表示.

2 方法为方便描述, 首先给出符号定义. 有标签源域数据和无标签目标域数据分别表示为

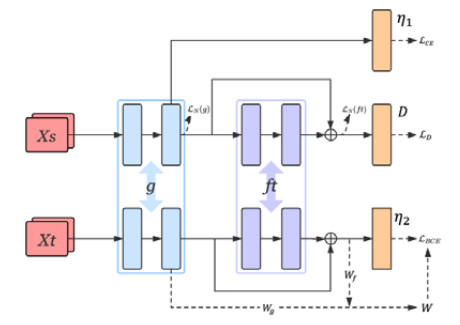

SUNDA将源域中样本对比知识迁移至目标域, 同时利用目标域的自监督知识指导知识迁移, 网络结构如图 2所示(实线箭头代表网络链接, 虚线箭头代表损失计算. 源域与目标域共享特征提取器g和域迁移网络ft). 其中: g为特征提取器; ft为域迁移网络, 用于迁移源域中样本对比知识. 源域与目标域共享g和ft. D为域鉴别器, 用于区分源域和目标域样本. η1和η2分别为源域和目标域分类器, 由单层全连接网络构成, 节点数分别为源域和目标域中类别数.

|

图 2 模型框架图 |

SUNDA的学习流程描述如下.

1) 首先, 通过自监督学习g的初始参数, 并在后续学习中固定g的部分参数, 用于保存源域和目标域信息;

2) 使用源域数据计算类对比损失(图中

3) 利用目标域特征构造伪标签矩阵W(图中Wg和Wf为不同层特征所得伪标签矩阵, 结合Wg和Wf计算W), 并通过伪标签矩阵计算基于自监督的分类损失, 实现目标域分类.值得注意的是, 步骤3)与步骤2)同时进行.

2.1 自监督预训练由于域间标签空间无交集, 源域知识迁移可能会使学习模型偏重源域学习, 导致目标域中有用信息的丢失. 自监督学习已被证明能在无类标注信息时产生有利于下游任务的底层特征. 鉴于此, SUNDA利用自监督预训练提取源域与目标域的底层特征, 并在后续训练中固定网络中前几层参数, 用于保存目标域信息.

首先, 将源域和目标域数据合并X=Xs∪Xt, 并将样本随机旋转[26]得到

| Lpre=−1N+MN∑i=1ˆyilogη(zi) | (1) |

其中, zi为样本xi经特征提取器g的生成特征, 即zi=g(xi); 同η1和η2, η为包含4个节点的单层分类网络. 同理, 其他自监督方式, 如对比型simCLR和MoCo等方法, 也可用于提取底层特征. 这里仅以旋转方式为例, 验证SUNDA的有效性.

2.2 基于样本对比知识迁移的域适应由于源域和目标域间无任何共享类别, 本文将源域与具体类别标签无关的类对比知识迁移至目标域, 以产生强判别能力特征.

● 类对比知识

源域Xs先后经特征提取器g和域迁移网络ft生成特征g(Xs)和ft(g(Xs)), 在两种特征上分别计算Npair损失[29], 并结合源域交叉熵损失, 得到基于源域的优化目标:

| Lconstrastive=12(LN(g)+LN(ft))+LCE(Xs,Ys) | (2) |

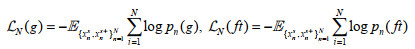

其中,

|

(3) |

| pn(g)=exp(g(xsn)Tg(xs+n))N∑k=1exp(g(xsn)Tg(xs+k)), pn(ft)=exp(ft(g(xsn))Tft(g(xs+n)))N∑k=1exp(ft(g(xsn))Tft(g(xs+k))) | (4) |

公式(4)中, xn和

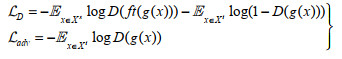

● 对抗域适应

由于域间无共享类别, SUNDA采用不同于DANN的非对称域对齐方式(若g(x)=ft(g(x)), 则与DANN相同). 具体地, 训练域判别器D用于区分经域迁移网络ft的源域数据和经特征提取器g的目标域数据, 同时训练特征提取器g和域迁移网络ft以混淆域判别器. 非对称域判别损失刻画如下:

|

(5) |

在获得目标域判别型特征的同时, 需对目标域数据进行分类. SUNDA通过基于图的自监督学习方式获得目标域样本对的伪标签, 用于指导知识迁移, 同时解决NSDA中目标域分类问题.

● 基于图的相似矩阵

基于cosine距离计算目标域特征g(Xt)和ft(g(Xt))上样本对的相似性矩阵Sg和Sf, 公式如下:

| Sgij=zgi⋅zgj||zgi||2||zgj||2, Sfij=zfi⋅zfj||zfi||2||zfj||2 | (6) |

其中, ⋅为向量点积,

● 基于图的伪标签矩阵

获得相似性矩阵Sg和Sf后, 通过阈值法[28]构造样本对伪标签矩阵Wg和Wf:

| Wgij={1, if Sgij⩾thres0, otherwise, Wfij={1, if Sfij⩾thres0, otherwise | (7) |

若两样本间相似性大于所设阈值thres, 则属于同一类别(

标域伪标签矩阵可表示为

| W=(Wg≥thres)|(Wf≥thres) | (8) |

其中, A|B代表A, B矩阵内对应位置的逻辑或运算. 若Wij=1(True), 表明样本xi和xj属于同类; 反之, Wij=0 (False), 则xi和xj属于不同类别. 实际上, 自监督预训练有助于提升初始伪标签矩阵的准确率.

● 基于伪标签的分类损失

获得伪标签矩阵W后, 希望通过伪标签实现目标域分类. 在目标域分类器η2的输出空间上计算样本内积

出空间的相似性. 结合伪标签矩阵W, 可得目标域分类损失:

| LBCE=−1M2M∑i=1M∑j=1[Wijlogη2(zti)Tη2(ztj)+(1−Wij)(log(1−η2(zti)Tη2(ztj)))] | (9) |

● 基于数据增强的伪标签分类损失

进一步改造公式(9), 提出了基于数据增强的

| LBCE=−1M2M∑i=1M∑j=1[Wijlogη2(ˆzti)Tη2(ztj)+(1−Wij)(log(1−η2(ˆzti)Tη2(ztj)))] | (10) |

鲁棒的学习模型应对同一样本的不同变换保持输出不变性[30, 31], 一致性损失也普遍应用于半监督学习中[32]. 给定样本x和变换T, 定义变换后的样本

| Lcon=1NN∑i=1(η1(zsi)−η1(ˆzsi))2+1MM∑i=1(η1(zti)−η1(ˆzti))2 | (11) |

其中,

最终, SUNDA的优化目标可刻画如下:

| Lg,ft,η1,η2=Lconstrastive+λLadv+αLBCE+ω(t)Lcon | (12) |

|

(13) |

最小化

算法1. 基于自监督知识的无监督新集域适应学习.

输入: 有标签源域数据

输出: 目标域数据

//自监督预训练

1. 将源域和目标域数据合并, 且旋转得到

2. for each epoch do

3.

4. 更新θg, θη

//源域样本对比知识迁移和目标域分类

5. for each epoch do

6. 计算伪标签矩阵W //Eq.8.

7. for each minibatch do

8. //交替优化, 实现对抗

9.

10. 更新θD

11.

12. 更新

13. end

14. end

3 实验与结果本文实验分为3个部分: 首先, 在数字数据集和人脸数据集上与现有方法进行性能对比; 其次, 基于消融实验验证SUNDA模型中各损失的有效性; 最后, 对阈值参数thres进行敏感性分析.

据笔者所知, 在NSDA任务下, 目前尚无基于域适应的目标域分类方法. 因此, 将SUNDA与无监督域适应DANN、无监督聚类K-means、DEC、DAC、JULE-SF和DCC, 以及发现新类AutoNovel方法进行性能对比. DANN面向closeset问题, 使用对抗学习实现域间分布对齐. 在无监督聚类方法中, K-means为非深度聚类方法, 其他方法均为深度学习方法. DEC使用自编码器重构损失进行预训练, 使用聚类分配强化损失对网络进行微调, 同时, 通过最小化软标签分布和辅助目标分布间的KL散度改善聚类结果. DAC将聚类转化为成对样本的二分类问题. JULE-SF使用CNN特征进行层次聚类以确定类别标签, 同时根据聚类特点设计损失函数, 对CNN特征进行调整. DCC采用连续聚类(RCC), 无需聚类数目的先验信息. 发现新类方法AutoNovel采用自监督预训练和伪标签方式实现目标域分类.

由于域间无共享类别, 且目标域的类别标签未知, 无法将预测标签与真实标签一一对应. 如预测标签的第五类可能对应真实标签的第一类. 为此, 采用聚类准确率(ACC)评估算法的学习性能, 定义如下:

| ACC=maxmn∑i=11{li=m(ci)}n | (14) |

其中, li为样本的真实标签, ci是预测标签, m为所有可能的聚类和类别间映射. 通过Hungarian算法[34]进行优化, 求解不同映射下的最大ACC值.

3.1 数字数据集分类任务本组实验研究SUNDA在MNIST, USPS和SVHN数据集上, 无域间共享类别下的迁移性能. 实验选择4组跨域分类实验来评估聚类准确率: 1) MNIST到USPS; 2) USPS到MNIST; 3) SVHN到MNIST; 4) SVHN到USPS. 每组实验将数字0~4作为源域, 5~9作为目标域.

MNIST由250个不同人的手写数字构成, 包括60 000张训练图片和10 000张测试图片, 每张图片的大小为1×28×28(通道×长×宽). USPS是从美国邮政采集的手写数字, 包括999张训练图片和250张测试图片, 每张图片的大小为1×16×16. SVHN是通过谷歌街景采集的门牌号数据, 包括4 578张训练图片和1 627张测试图片, 每张图片的大小为3×32×32. 实验中, 将MNIST和USPS放缩至1×32×32, 使用通道拷贝将单通道转变为三通道3×32×32, 每张的图片像素都归一化至[0, 1]之间.

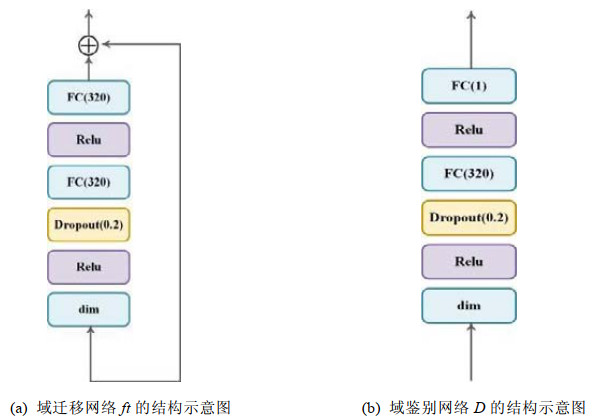

实验使用ResNet-18作为特征提取器. 域迁移网络使用两层全连接网络(dim-320-320-dim)和残差网络将输入向量映射为维度相同的向量, 如图 3(a)所示, dim为输入维度. 域分类网络包含两层全连接层(dim-320- 320-1), 如图 3(b)所示. 所有参数采用SGD进行更新, 学习速率为3e−3, 阈值thres为0.95, 超参数λ和α分别使用0.3和1.

|

图 3 |

实验将SUNDA与无监督域适应和无监督聚类算法进行对比, 结果见表 1. 表中第1列(METHOD)代表对比方法, 最后一列(avg)为不同方法的平均性能, 中间列为各方法在各迁移任务上聚类准确率. 基于表 1可发现: 由于域间无共享类别, DANN实现域分布对齐和源域判别知识迁移, 并不能获得令人满意的学习性能. 而关注对比知识迁移, 同时使用非对称分布对齐, SUNDA获得了显著的提升. 相比于非深度聚类K-means, SUNDA同样也有显著的性能提升. 但相比于其他深度聚类的方法, 如DCC, JULE-SF等, DANN性能仅有小幅提升. 原因在于数字数据相对简单, 网络提取的特征容易区分, 因此无域适应的深度聚类方法已经能够获得比较好的学习效果. 接下来, 将利用更为复杂的人脸数据集, 验证SUNDA的有效性.

| 表 1 数字数据集目标域分类准确率(最好的准确率进行加粗) |

此外, 验证了SUNDA在域间存在交集场景下的有效性. 在域间无交集场景中, 源域包含0~4数字类别, 目标域包含5~9数字类别. 为产生交集类别, 将源域类别依次去除{0, 1, 2, 3, 4}类, 同时增加{5, 6, 7, 8, 9}类, 分别设计5组实验场景, 如表 2所示.

| 表 2 域间存在交集的5种场景 |

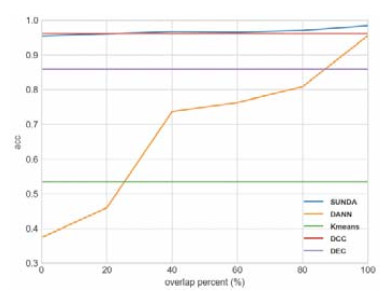

图 4展示了USPS到MINIST任务上各对比方法在上述场景下的学习性能, 其中, 横轴为重叠比例, 纵轴为学习性能. 可以看出: 1) 因目标域类别恒定, 聚类方法的学习性能保持不变. 而随域间重叠类别逐渐增多, DANN和SUNDA的学习性能都逐渐提升. 因此, 域间重叠知识越多, 源域知识迁移对目标域学习越有利; 2) 在该学习任务上, 当域间无重叠类别时, SUNDA的性能稍差于深度聚类方法DCC的性能. 但随重叠类别逐渐增加, SUNDA的性能不断提升, 超越DCC性能, 验证了源域相关知识的合理利用可有效辅助目标域学习; 3) 在上述5组实验场景下, SUNDA的性能皆优于DANN的性能, 甚至包括类别完全重叠场景, 验证了SUNDA的有效性.

|

图 4 域间类别存在交集下性能对比 |

进一步, 在跨种族人脸数据上进行对比实验. 人脸数据按照人种划分域, 包括白人、黑人和黄种人. 两两配对, 共设计6组迁移任务评估SUNDA的学习性能: 1) 白人到黑人; 2) 黑人到白人; 3) 白人到黄种人; 4) 黄种人到白人; 5) 黑人到黄种人; 6) 黑人到白人.

MS-1M[38]为微软公司从网络采集的人脸照片, 本组实验所使用人脸数据为从MS-1M中采样并对种族信息进行标注. 其中, 白人包含13类共1 025张图片, 黑人包含10类共739张图片, 黄种人包含10类共825张图片. 将所有图片缩放至3×110×110并将像素归一化至[0, 1]之间. 人脸图片受到光线、角度、年龄等因素影响, 相比于数字数据集场景更加复杂, 更具挑战性.

特征提取器的网络结构与文献[39]中相似, 如表 3所示. 域迁移网络和域分类网络与数字数据集任务中相同, 如后文图 5所示. 所有参数采用SGD进行更新, 学习率为9e−3, 阈值thres为0.9, 超参数λ和α分别使用0.3和5.

| 表 3 人脸数据集实验使用的特征提取器g的结构 |

|

图 5 参数thres取值对准确率的影响 |

实验将SUNDA与无监督域适应、无监督聚类算法和发现新类方法进行对比, 实验结果见表 4. 从表 4中可以看出, SUNDA在所有迁移任务上的学习性能都显著优于对比方法的性能. 与数字数据集不同, 人脸场景复杂且不同类别间相似度大, 因此实验中所有聚类算法均无法获得较好的学习性能. 发现新类方法AutoNovel采用伪标签方式对目标域进行划分, 而源域与目标域为跨种族人脸数据, 域间差异较大, 源域数据训练下的网络(无样本对比知识迁移)对目标域伪标签的获取可能并无帮助, 甚至产生负面影响, 最终导致学习性能差于K-means的性能.

| 表 4 人脸数据集目标域分类准确率 |

综上, 在数字数据集和人脸数据集上, SUNDA都取得了较好的学习性能. 在数字数据集上, 与DCC进行对比, SUNDA的学习性能并没有很明显的优势. 而在人脸数据集上, SUNDA相较于无监督聚类、无监督域适应以及发现新类方法均取得明显的性能提升. 此外, 在数字数据集上, 无监督聚类方法获得了较好的学习性能, 但到人脸数据集并不能很好地发挥作用. 但与此同时, SUNDA依然可以获得较好的学习效果. 由此可见, SUNDA在NSDA任务中能够充分利用源域知识辅助目标域识别, 提升目标域学习性能.

3.3 消融实验为了进一步验证方法每一部分的有效性, 本组实验将在白人到黄种人的场景下进行消融实验. 实验包括4个损失: 1) 类对比损失; 2) 对抗域适应损失(

| 表 5 消融实验 |

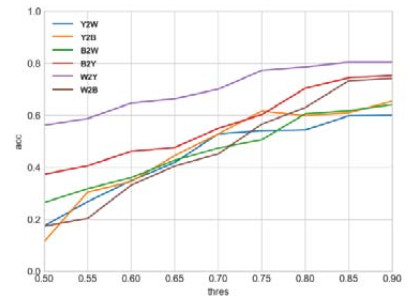

本节对阈值参数thres对SUNDA学习性能的影响进行分析, 通过参数thres挑选正样本对, 用于基于图的自监督分类. 在人脸数据6组迁移任务上进行实验, 实验结果如图 5所示. 其中, Y, W和B分别代表黑人、白人和黄种人的人脸数据. 横坐标为thres的值, 纵坐标为SUNDA的学习性能. 从图可看出: 随着thres的增加, SUNDA的分类效果整体逐步变好. 原因在于: 本文基于cosine距离, 通过thres挑选正样本对形成样本对伪标签, 随thres增大, 样本对的准确率将逐步提升, 从而使SUNDA的分类愈加准确.

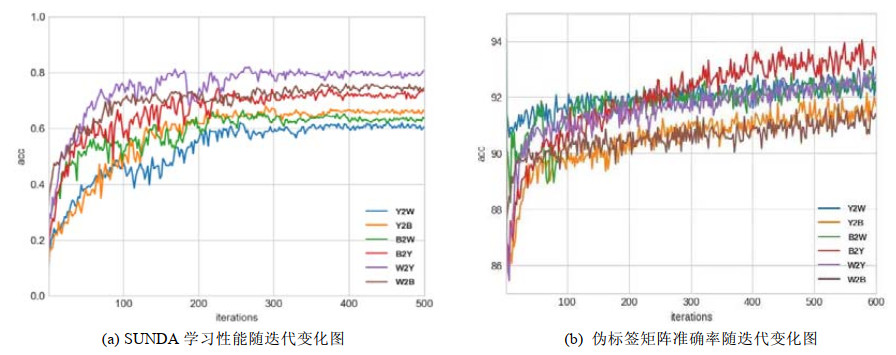

3.5 方法稳定性分析为探究SUNDA的稳定性, 绘制了在人脸数据集的6组迁移任务上, SUNDA学习性能随迭代的变化图, 如图 6(a)所示. 其中, 横坐标为迭代次数, 纵坐标为SUNDA的分类性能. 由图可知: SUNDA的学习性能随迭代次数的增加, 基本呈上升趋势, 并逐渐趋于稳定, 验证了SUNDA的稳定性. 此外, SUNDA利用基于图的自监督分类, 指导源域知识迁移, 其中, 伪标签矩阵由样本对cosine距离和阈值法获得. 图 6(b)给出伪标签矩阵准确率随迭代的变化图, 其中, 横坐标为迭代次数, 纵坐标为样本对伪标签准确率. 由图可知: 伪标签矩阵的初始准确率基本在80%以上, 且随迭代的进行, 准确率呈不断上升趋势, 可对源域知识迁移进行有效指导, 进一步验证了基于图的自监督分类的有效性以及方法的稳定性.

|

图 6 |

针对无监督域适应中, 源域与目标域类别标签集合完全不同的NSDA学习任务, 本文提出了SUNDA方法. 首先, 采用自监督学习初始特征, 通过对抗迁移源域的类对比知识, 帮助目标域学习判别特征. 同时采用了目标域基于图的自监督来指导模型的学习, 并解决了异构标签空间下目标域的分类问题. 实验结果表明: 与无监督域适应和无监督聚类方法以及新类发现方法相比较, SUNDA的学习效果得到了显著的提升. 此外, 在开放集域适应中, 当前学习方法将目标域中的私有类都归为未知类. 实际上, 可以考虑将以往开放集域适应的方法与本文相结合, 在对共享类实现对齐和分类的同时, 实现域私有类准确分类.

| [1] |

Zhuang F, Qi Z, Duan K, et al. A comprehensive survey on transfer learning. Proc. of the IEEE, 2020, 109(1): 43-76.

https://ieeexplore.ieee.org/abstract/document/9134370 |

| [2] |

Wilson G, Cook DJ. A survey of unsupervised deep domain adaptation. ACM Trans. on Intelligent Systems and Technology (TIST), 2020, 11(5): 1-46.

https://www.ncbi.nlm.nih.gov/pmc/articles/PMC8323662/ |

| [3] |

Wang W, Zheng VW, Yu H, et al. A survey of zero-shot learning: Settings, methods, and applications. ACM Trans. on Intelligent Systems and Technology (TIST), 2019, 10(2): 1-37.

https://dlnext.acm.org/doi/10.1145/3293318 |

| [4] |

Pang N, Zhao X, Wang W, et al. Few-shot text classification by leveraging bi-directional attention and cross-class knowledge. Sciece China Information Sciences, 2021, 64(3): 29-41.

https://link.springer.com/article/10.1007/s11432-020-3055-1 |

| [5] |

Han K, Vedaldi A, Zisserman A. Learning to discover novel visual categories via deep transfer clustering. In: Proc. of the IEEE/ CVF Int'l Conf. on Computer Vision. 2019. 8401-8409.

|

| [6] |

Long M, Cao Y, Wang J, et al. Learning transferable features with deep adaptation networks. In: Proc. of the Int'l Conf. on Machine Learning. PMLR, 2015. 97-105.

|

| [7] |

Kullback S, Leibler RA. On information and sufficiency. Annals of Mathematical Statistics, 1951, 22(1): 79-86.

[doi:10.1214/aoms/1177729694] |

| [8] |

Arjovsky M, Chintala S, Bottou L. Wasserstein generative adversarial networks. In: Proc. of the Int'l Conf. on Machine Learning. PMLR, 2017. 214-223.

|

| [9] |

Ganin Y, Ustinova E, Ajakan H, et al. Domain-adversarial training of neural networks. Journal of Machine Learning Research, 2016, 17(59): 1-35.

https://www.jmlr.org/papers/volume17/15-239/15-239.pdf |

| [10] |

Wang YY, Gu JM, Wang C, et al. Discrimination-aware domain adversarial neural network. Journal of Computer Science and Technology, 2020, 35: 259-267.

[doi:10.1007/s11390-020-9969-4] |

| [11] |

Saito K, Watanabe K, Ushiku Y, et al. Maximum classifier discrepancy for unsupervised domain adaptation. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2018. 3723-3732.

|

| [12] |

Zhu JY, Park T, Isola P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2017. 2223-2232.

|

| [13] |

Hoffman J, Tzeng E, Park T, et al. Cycada: Cycle-consistent adversarial domain adaptation. In: Proc. of the Int'l Conf. on Machine Learning. PMLR, 2018. 1989-1998.

|

| [14] |

Cao Z, Long M, Wang J, et al. Partial transfer learning with selective adversarial networks. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2018. 2724-2732.

|

| [15] |

Zhang J, Ding Z, Li W, et al. Importance weighted adversarial nets for partial domain adaptation. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2018. 8156-8164.

|

| [16] |

Cao Z, You K, Long M, et al. Learning to transfer examples for partial domain adaptation. In: Proc. of the IEEE/CVF Conf. on Computer Vision and Pattern Recognition. 2019. 2985-2994.

|

| [17] |

Panareda Busto P, Gall J. Open set domain adaptation. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2017. 754-763.

|

| [18] |

Liu H, Cao Z, Long M, et al. Separate to adapt: Open set domain adaptation via progressive separation. In: Proc. of the IEEE/CVF Conf. on Computer Vision and Pattern Recognition. 2019. 2927-2936.

|

| [19] |

Saito K, Yamamoto S, Ushiku Y, et al. Open set domain adaptation by backpropagation. In: Proc. of the European Conf. on Computer Vision (ECCV). 2018. 153-168.

|

| [20] |

Jo I, Kim J, Kang H, et al. Open set recognition by regularising classifier with fake data generated by generative adversarial networks. In: Proc. of the 2018 IEEE Int'l Conf. on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2018. 2686-2690.

|

| [21] |

You K, Long M, Cao Z, et al. Universal domain adaptation. In: Proc. of the IEEE/CVF Conf. on Computer Vision and Pattern Recognition. 2019. 2720-2729.

|

| [22] |

Saito K, Kim D, Sclaroff S, et al. Universal domain adaptation through self supervision. arXiv: 2002.07953, 2020.

|

| [23] |

Zhang R, Isola P, Efros AA. Colorful image colorization. In: Proc. of the European Conf. on Computer Vision. Cham: Springer, 2016. 649-666.

|

| [24] |

Doersch C, Gupta A, Efros AA. Unsupervised visual representation learning by context prediction. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 1422-1430.

|

| [25] |

Noroozi M, Favaro P. Unsupervised learning of visual representations by solving jigsaw puzzles. In: Proc. of the European Conf. on Computer Vision. Cham: Springer, 2016. 69-84.

|

| [26] |

Gidaris S, Singh P, Komodakis N. Unsupervised representation learning by predicting image rotations. arXiv: 1803.07728, 2018.

|

| [27] |

He K, Fan H, Wu Y, et al. Momentum contrast for unsupervised visual representation learning. In: Proc. of the IEEE/CVF Conf. on Computer Vision and Pattern Recognition. 2020. 9729-9738.

|

| [28] |

Chen T, Kornblith S, Norouzi M, et al. A simple framework for contrastive learning of visual representations. In: Proc. of the Int'l Conf. on Machine Learning. PMLR, 2020. 1597-1607.

|

| [29] |

Sohn K. Improved deep metric learning with multi-class n-pair loss objective. In: Proc. of the 30th Int'l Conf. on Neural Information Processing Systems. 2016. 1857-1865.

|

| [30] |

Li YF, Liang DM. Safe semi-supervised learning: A brief introduction. Frontiers of Computer Science, 2019, 13(4): 669-676.

[doi:10.1007/s11704-019-8452-2] |

| [31] |

Feng J, Wang X, Liu W. Deep graph cut network for weakly-supervised semantic segmentation. Science China Information Sciences, 2021, 64(3): 130105.

[doi:10.1007/s11432-020-3065-4] |

| [32] |

Oliver A, Odena A, Raffel C, et al. Realistic evaluation of deep semi-supervised learning algorithms. arXiv: 1804.09170, 2018.

|

| [33] |

Laine S, Aila T. Temporal ensembling for semi-supervised learning. arXiv: 1610.02242, 2016.

|

| [34] |

Kuhn HW. The Hungarian method for the assignment problem. Naval Research Logistics, 2010, 52(1-2): 7-21.

|

| [35] |

Shah SA, Koltun V. Deep continuous clustering. arXiv: 1803.01449, 2018.

|

| [36] |

Xie J, Girshick R, Farhadi A. Unsupervised deep embedding for clustering analysis. In: Proc. of the Int'l Conf. on Machine Learning. 2016.

|

| [37] |

Yang J, Parikh D, Batra D. Joint unsupervised learning of deep representations and image clusters. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2016. 5147-5156.

|

| [38] |

Guo Y, Zhang L, Hu Y, et al. Ms-celeb-1m: Challenge of recognizing one million celebrities in the real world. Electronic Imaging, 2016, 2016(11): 1-6.

https://www.ingentaconnect.com/content/ist/ei/2016/00002016/00000011/art00013 |

| [39] |

Sohn K, Liu S, Zhong G, et al. Unsupervised domain adaptation for face recognition in unlabeled videos. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2017. 3210-3218.

|

| [40] |

Chang JL, Wang LF, Meng GF, Xiang SM, Pan CH. Deep adaptive image clustering. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2017. 5879-5887.

|

| [41] |

Ehrhardt S, Zisserman A, Rebuffi SA, et al. Automatically discovering and learning new visual categories with ranking statistics. In: Proc. of the 8th Int'l Conf. on Learning Representations (ICLR). 2020.

|